指尖在键盘上的每次敲击,都伴随着RGB灯光的绚烂闪动,宛如在键盘上演出夺目的光影秀,从流光溢彩的渐变,到震撼人心的波浪,再到动感十足的呼吸灯效,各种灯光模式绚丽夺目,再加上流畅的回馈手感,让游戏或打字体验变成了视觉与触觉的双重享受。

机械键盘的各种神奇魔力,均源自核心主控芯片MCU的加持。正是新一代MCU具有的强大性能和扩展功能,才不断重塑机械键盘的边界,使其不仅能实现更多样化的功能,还极大增强个性化定制的空间,进一步展现了科技创新带来的无限魅力。

市场与技术的双轮驱动

机械键盘早已从极客的最爱变成大众的选择。据Market Research Future(MRFR)的综合报告,机械键盘市场将以12.7%的复合年增长率增长,2030年市场规模将达到36.3亿美元。

这种走红并非偶然。首先,机械键盘的每个按键都采用独立的机械开关,带来清晰的触觉反馈和完美的按压感。红轴顺滑,青轴清脆,茶轴平衡,无论是追求速度的电竞选手,还是偏爱打字的作家,都能找到属于自己的绝佳手感。

其次,机械键盘配备多种RGB背光模式,用户可以随心所欲地定制灯光颜色、亮度和动态效果。完美的敲击感和光韵流转的动态灯光模式,可根据游戏场景的变化调整灯光颜色,让用户可以沉浸在紧张刺激的游戏体验中。

要让机械键盘充满魅力,选择一个高效的核心MCU就变得尤为关键。作为机械键盘的核心组件,MCU承担着处理输入、输出以及与其他设备通信的重要任务,从而确保键盘能够顺利执行包括宏编程、背光调节和游戏模式在内的各种复杂功能。因此在选择MCU的过程中,应当高度重视其在处理速度、低功耗设计、程序可移植性、硬件扩展能力等方面的综合性能表现。

首先,机械键盘需要MCU具备足够的处理能力来支持高回报率、无延迟的实时响应控制。其次,随着用户对机械键盘功能的不断增加,如背光灯控制、多模式切换等,对MCU的硬件扩展能力提出了更高的要求。第三,低功耗设计对于机械键盘长时间使用的场景至关重要。最后,在选择MCU时,不仅要考虑性能,还要考虑其在不同应用中的可移植性和开发便利性。因此,MCU不但要具有足够的处理能力,还要有能力去利用这些技术来提供更丰富的用户体验。

以这些要素来衡量,兆易创新最新推出的GD32L235将是一个非常合适的选择。GD32L235基于ARM® Cortex® -M23内核,主频最大64MHz,向下兼容M0/M0+内核产品。其新增的WLCSP25超小尺寸封装非常适用于可穿戴设备、便携式设备等有限的硬件空间应用场景。最为重要的是,该系列紧贴低功耗市场需求,拥有更优的功耗效率、丰富的接口资源、更高性价比,非常适合机械键盘等PC外设应用。

从能效到灯效尽在GD32L235掌控中

与所有电子设备相同,功耗也是机械键盘性能的重要评判指标。尤其是无线机械键盘,如果采用三模(BLE/2.4G/USB)方式,再配置RGB背光,续航就将成为决定产品使用体验的关键。而作为整个键盘调度中心的MCU,其功耗特性将决定整个机械键盘的表现。

GD32L235系列在功耗方面表现出色。其针对功耗效率方面进行了一系列优化提升,支持包括深度睡眠(Deep-sleep)、部分睡眠(Sleep)和待机(Standby)等6种低功耗模式。在深度睡眠(Deep-sleep)模式下,电流降至1.8uA,唤醒时间低于2uS;待机(Standby)模式电流更是低至0.26uA。即使在最高主频全速工作模式下,其功耗也仅为66uA/MHz,实现了效能和功耗间的卓越平衡。

同时,在设计高性能机械键盘时,对MCU的PWM通道数量、I/O资源以及Flash存储能力提出了严格要求。GD32L235系列微控制器恰如其分地满足了这些高阶需求,展现了其在机械键盘领域的适应性。

如前文所述,RGB灯效已成为机械键盘受到消费者推崇的主要原因。如果要实现复杂绚丽的RGB背光效果,MCU的多路PWM输出能力必不可少。具体到GD32L235系列,其拥有多达11个定时器,包括2个16位低功耗定时器、6个通用16位定时器、1个高级定时器和2个基本定时器,充分满足了复杂RGB灯光效果的控制需求,使键盘能够呈现从静态色彩到动态光谱流转的全方位视觉体验。并且,这些丰富的PWM资源,也可以为机械键盘省去专门的灯光控制芯片,从而降低整个系统的功耗和成本。

考虑到键盘矩阵扫描与独立LED控制的双重需求,GD32L235还提供多个I/O接口,实现高效的信号检测与灯光指示功能的复用,确保键盘在高响应速度与复杂功能集成之间的完美平衡。具体而言,该系列集成2个低功耗LPUART、2个USART、2个UART、3个I2C、2个SPI等通用外设接口,还配备1个CAN2.0控制器和1个USB 2.0 FS控制器等标准通信接口。模拟外设方面,该产品系列配备1个12位ADC,支持差分输入和单端输入两种模式,提高了ADC模块的精度和性能;还集成1个12位DAC和2个比较器。这些丰富的外设资源不仅优化了硬件布局,还简化了布线复杂度,为开发者提供了极大的灵活性。

此外,GD32L235内置的Flash资源,最大支持128KB eFlash,不仅支持存储密集型的固件程序,还便于配合上位机驱动,实现软件层面的深度定制与升级,为用户提供更加丰富和流畅的操作体验。这不仅提升了键盘的可扩展性,还为未来功能的迭代预留了充足的空间。

有线和无线方案双发力

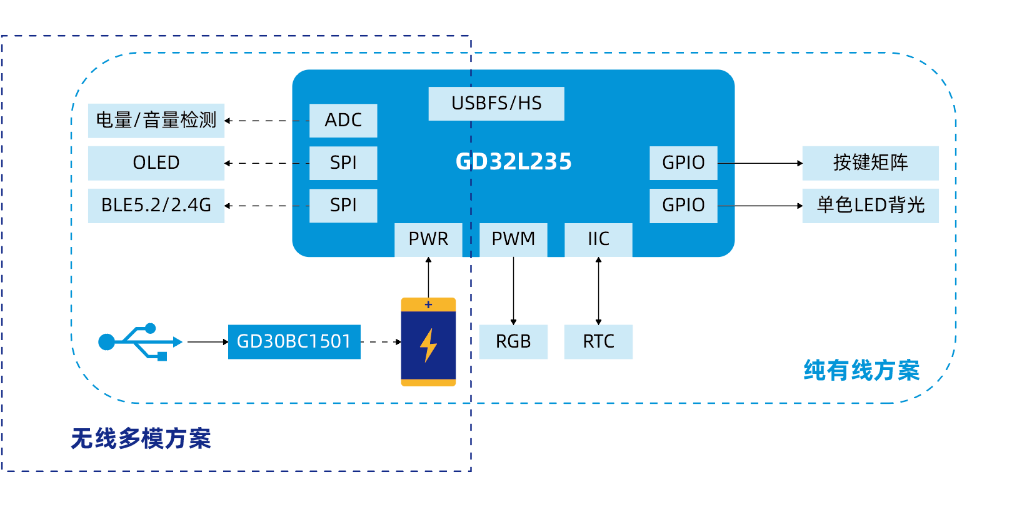

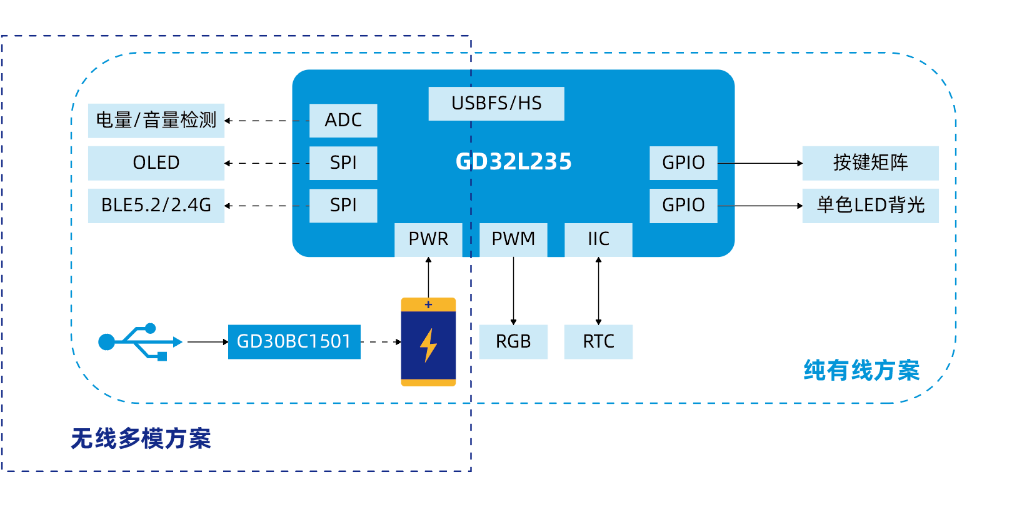

以GD32L235为核心,兆易创新的合作伙伴深圳智芯云技术有限责任公司基于GD32L235开发了全功能机械键盘解决方案,可助力客户实现丰富的功能和高度可定制性。

图 基于GD32L235的全功能机械键盘解决方案

有线机械键盘作为主流产品,可充分发挥绚丽的RGB灯效。为此,该方案能实现每颗RGB独立控制,支持256级PWM;实现全彩控制,1600万色设定,内置20种炫酷灯效,支持客户自定义灯效。同时,自主研发的上位机QT平台支持多种系统,可以实现灯光设置、屏幕设置、宏编辑、Fn层设置等键盘配置。

这款有线方案还具备多按键模式,全键无冲;支持1000Hz回报率;可根据客户需要定制78/87/104键等不同键值的数目需求,支持多国语言版本;支持在线USB升级固件;响应PC休眠进入休眠、按键或PC唤醒;支持Win、Mac、Linux、安卓等系统。

相对有线方案,无线方案更偏重能效和连接的稳定性。为此,该无线方案增加以下功能:支持大容量1-2节锂电池充放电管理;无线模式下超低运行功耗远低于行业标准;USB/2.4G同时支持1kHz稳定回报率;具备更低的睡眠功耗,一级低功耗模式下<200uA,二级休眠模式下<100uA;多种连接模式切换逻辑可自定义;支持硬件开关/旋钮切换,支持自定义各种快捷键切换;支持在线USB/无线升级固件。

搭配智芯云自有的上位机系统,客户可以配置不同RGB灯效、RGB刷新速度、LCD屏显示效果等炫酷场景,根据不同场景的需求定制出不同的终端产品。

为了便于客户的产品能迅速推向市场,兆易创新还配备丰富的开发资源。GD32L235系列配套的文档手册及软件资源已经可以下载,针对GD32L235系列不同封装和管脚配置的配套开发工具也已同步推出。

除去GD32L235,兆易创新的MCU产品家族中还有GD32F303也可用于机械键盘方案的开发。该芯片采用ARM® Cortex® -M4核心,最高主频可达120MHz,支持高速DSP运算,具备完整的DSP指令集、并行计算能力和专用浮点运算单元(FPU)。兆易创新与合作伙伴已经推出了基于GD32F303 MCU的QMK固件机械键盘解决方案,并得到市场的好评。

机械键盘市场正以前所未有的速度蓬勃发展,而高性能MCU的不断涌现,成为推动这一市场迅猛增长的关键驱动力。这些先进的MCU不仅提升了键盘的响应速度,实现了近乎零延迟的输入反馈,还极大地丰富了自定义功能和灯光效果,可满足从专业电竞选手到日常办公用户多元化、个性化的需求。随着物联网、人工智能技术与机械键盘的深度融合,MCU在能效比、集成度以及智能化处理能力上的持续突破,正引领着机械键盘行业向更加智能、高效、定制化的方向演进。

欲了解更多基于GD32L235系列MCU全功能机械键盘的方案详情,请咨询Solution_GD@gigadevice.com。