基于先进的 NVIDIA 网络、NVIDIA 全栈 AI 软件和存储技术,可将集群中 Grace Blackwell 超级芯片的数量扩展至数万个,通过 NVIDIA NVLink可将多达 576 块 Blackwell GPU 连成一个整体,由NVIDIA 系统专家加速即时 AI 基础设施的部署

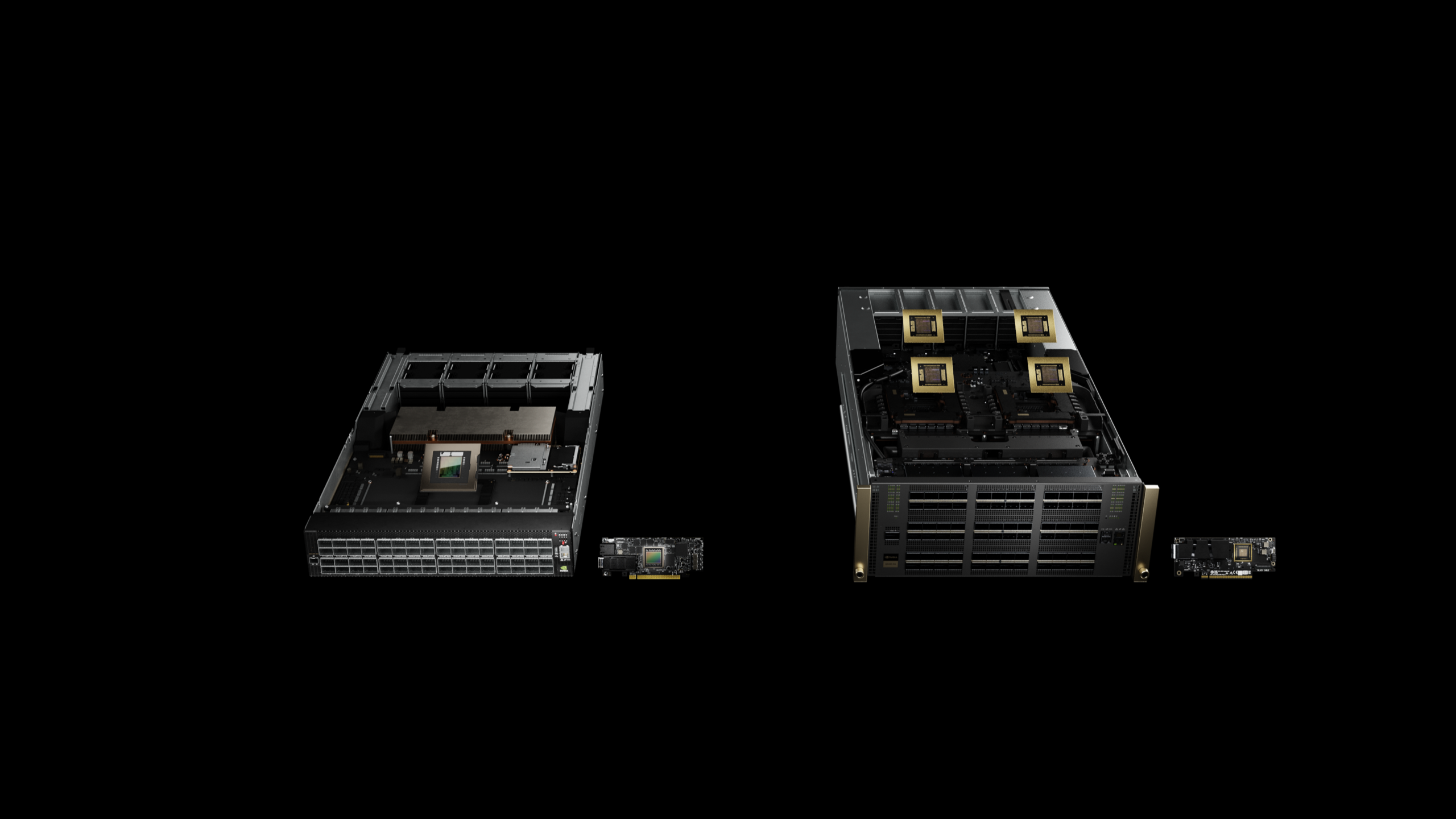

美国加利福尼亚州圣何塞—— GTC ——太平洋时间 2024 年 3 月 18 日 —— NVIDIA 于今日发布新一代 AI 超级计算机 —— 搭载 NVIDIA GB200 Grace Blackwell 超级芯片的 NVIDIA DGX SuperPOD™。这台 AI 超级计算机可以用于处理万亿参数模型,能够保证超大规模生成式 AI 训练和推理工作负载的持续运行。

全新 DGX SuperPOD 采用新型高效液冷机架级扩展架构,基于 NVIDIA DGX™ GB200 系统构建而成,在 FP4 精度下可提供 11.5 exaflops 的 AI 超级计算性能和 240 TB 的快速显存,且可通过增加机架来扩展性能。

每个 DGX GB200 系统搭载 36 个 NVIDIA GB200 超级芯片,共包含 36 个 NVIDIA Grace CPU 和 72 个 NVIDIA Blackwell GPU。这些超级芯片通过第五代 NVIDIA NVLink® 连接成一台超级计算机。与 NVIDIA H100 Tensor Core GPU 相比,GB200 超级芯片在大语言模型推理工作负载方面的性能提升了高达 30 倍。

NVIDIA 创始人兼首席执行官黄仁勋表示: “NVIDIA DGX AI 超级计算机是推进 AI 产业变革的工厂。新一代 DGX SuperPOD 集 NVIDIA 加速计算、网络和软件方面的最新进展于一体,能够帮助每一个企业、行业和国家完善并生成自己的 AI。”

Grace Blackwell 架构的 DGX SuperPOD 由 8 个或以上的 DGX GB200 系统构建而成,这些系统通过 NVIDIA Quantum InfiniBand 网络连接,可扩展到数万个 GB200 超级芯片。用户可通过 NVLink 连接 8 个 DGX GB200 系统中的 576 块 Blackwell GPU,从而获得海量共享显存空间,来赋能下一代 AI 模型。

面向生成式 AI 时代的全新机架级扩展的 DGX SuperPOD 架构

采用 DGX GB200 系统构建而成的全新 DGX SuperPOD 采用了统一的计算网络。除第五代 NVIDIA NVLink 网络外,还包括 NVIDIA BlueField®-3 DPU,并将支持同为今日发布的 NVIDIA Quantum-X800 InfiniBand 网络。这个架构可为计算平台中的每块 GPU 提供高达每秒 1800 GB 的带宽。

另外,第四代 NVIDIA 可扩展分层聚合和规约协议(SHARP)™技术可提供 14.4 teraflops 的网络计算能力,与上一代产品相比,新一代 DGX SuperPOD 架构的网络计算能力提高了 4 倍。

统包式架构搭配先进的软件,实现前所未有的正常运行时间

全新 DGX SuperPOD 是一台完整的数据中心级 AI 超级计算机,在与 NVIDIA 认证合作伙伴提供的高性能存储集成后,能够满足生成式 AI 工作负载的需求。每台超级计算机都在出厂前完成了搭建、布线和测试,从而大大加快了在用户数据中心的部署速度。

Grace Blackwell 架构的 DGX SuperPOD 具有智能预测管理功能,能够持续监控软硬件中的数千个数据点,通过预测并拦截导致停机和低效的根源以节省时间、能耗和计算成本。

即使没有系统管理员在场,该软件也能识别需要重点关注的领域并制定维护计划,灵活调整计算资源,通过自动保存和恢复作业来防止停机。

如果软件检测到需要更换组件,该集群将激活备用容量以确保工作能够及时完成。为任何必要的硬件更换做好安排,以免出现计划之外的停机。

NVIDIA DGX B200 系统推动各行各业 AI 超级计算发展

NVIDIA 还发布了一款统一用于 AI 模型训练、微调和推理的通用 AI 超级计算平台 NVIDIA DGX B200 系统。

采用风冷传统机架式设计的 DGX 已被全球各行各业数千家企业广泛采用,DGX B200 是 DGX 系列的第六代产品。采用 Blackwell 架构的全新 DGX B200 系统包含 8 个 NVIDIA B200 Tensor Core GPU 和 2 个第五代英特尔®至强®处理器。用户还可以使用 DGX B200 系统构建 DGX SuperPOD,打造能够帮助大型开发团队运行多种不同作业的 AI 卓越中心。

DGX B200 系统凭借全新 Blackwell 架构中的 FP4 精度特性,可提供高达 144 petaflops 的 AI 性能、1.4TB 海量的 GPU 显存和 64TB/s 的显存带宽,从而使得该系统的万亿参数模型实时推理速度比上一代产品提升了 15 倍。

DGX B200 系统包含带有 8 个 NVIDIA ConnectX™-7 网卡和 2 个 BlueField-3 DPU 的高性能网络,每个连接的带宽高达 400 Gb/s,可通过 NVIDIA Quantum-2 InfiniBand 和 NVIDIA Spectrum™-X 以太网网络平台支持更高的 AI 性能。

软件和专家为扩大生产级 AI 的规模提供支持

所有 NVIDIA DGX 平台均包含用于企业级开发和部署的 NVIDIA AI Enterprise 软件。DGX 用户可以通过使用该软件平台中的预训练的 NVIDIA 基础模型、框架、工具套件和全新 NVIDIA NIM 微服务来加速他们的工作。

NVIDIA DGX 专家与部分获得 NVIDIA DGX 平台支持认证的合作伙伴将在每个部署环节为用户提供帮助,以便其迅速实现 AI 投产。在系统投入运行后,DGX 专家还将继续协助用户优化其 AI 管线和基础设施。

供应情况

NVIDIA 全球合作伙伴预计将在今年晚些时候提供基于 DGX GB200 和 DGX B200 系统构建而成的 NVIDIA DGX SuperPOD。

更多信息,请观看 GTC 主题演讲回放或在 3 月 21 日前参加由 NVIDIA 和行业领导者带来的会议。

关于 NVIDIA

自 1993 年成立以来,NVIDIA (NASDAQ: NVDA) 一直是加速计算领域的先驱。NVIDIA 1999 年发明的 GPU 驱动了 PC 游戏市场的增长,并重新定义了现代计算机图形,开启了现代 AI 时代,正在推动跨市场的工业数字化。NVIDIA 现在是一家全栈计算基础设施公司,其数据中心规模的解决方案正在重塑整个行业。更多信息,请访问https://nvidianews.nvidia.com/ 。