作者:e络盟技术团队

AI与物联网系统的融合改变了数据的处理、分析与使用方式。多年以来,各种 AI 解决方案始终基于云端部署,而如今边缘 AI 的兴起,在提升运行效率、增强安全性和改善运营可靠性方面提供了颇有潜力的解决方案。本文旨在深入剖析边缘 AI 的复杂性,探究其构成要素、应用优势及其快速演进的硬件支持体系。

AI 演变:从云端到边缘

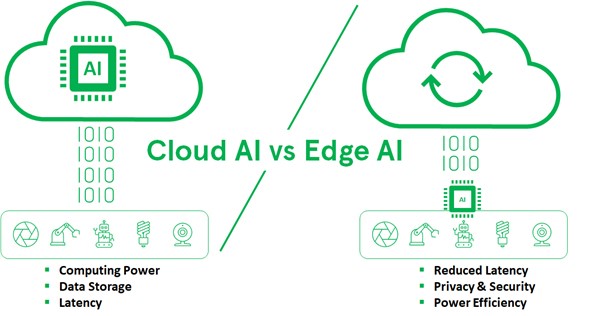

传统物联网设备直接依赖云端基础设施进行 AI 处理。边缘设备传感器产生的数据需要传输至云端进行分析和推理运算。然而,随着物联网应用对网络边缘实时决策需求的激增,这种模式面临着严峻挑战。涉及到海量的数据规模、延迟问题以及带宽限制,这让云端处理模式在许多应用场景中难以为继。

边缘AI的出现,将处理能力更靠近数据源——也就是物联网设备本身。这样的转变减少了持续将数据传输到云端的需求,并实现了一种对许多应用至关重要的实时处理方式,例如自动驾驶汽车、工业自动化和医疗保健等领域。

边缘 AI 系统的核心组件

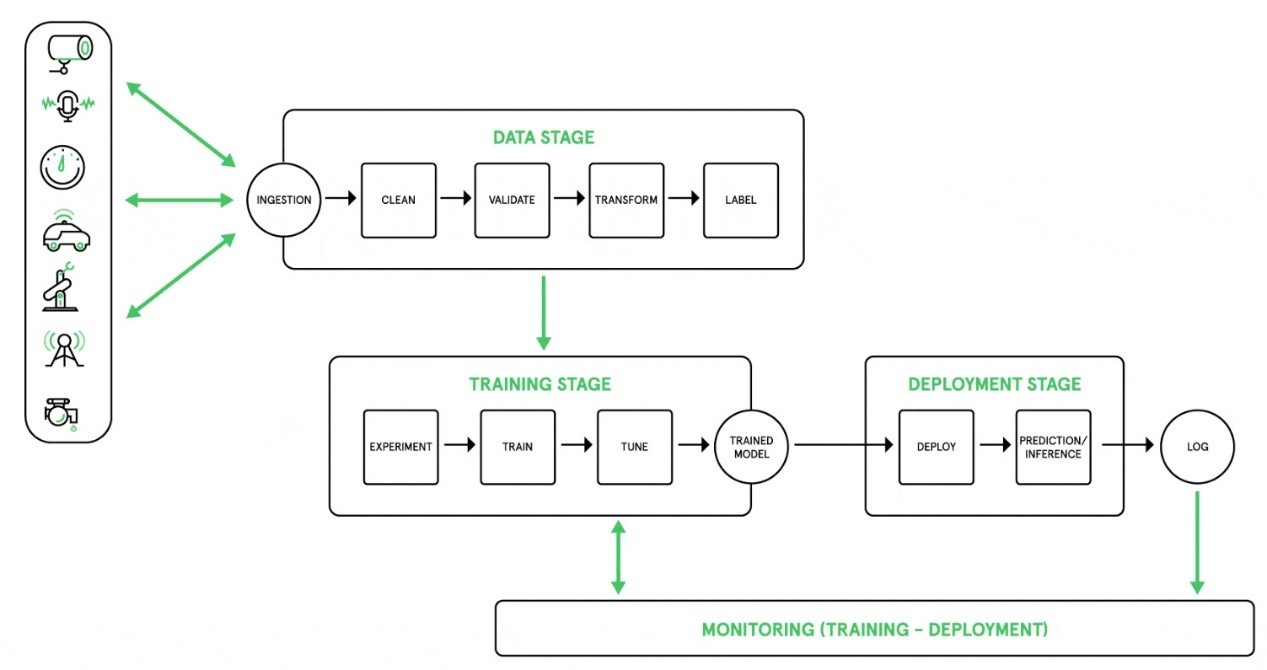

边缘 AI 系统由专用硬件与软件组件构成,具备本地化采集、处理和分析传感器数据等核心能力。边缘 AI 模型通常包含以下要素:

数据采集硬件:若未配备专用传感器并集成处理单元及存储器,数据采集将无法实现。现代传感器内置数据处理能力,可对数据进行初步筛选与转换。

训练与推理模型:边缘设备需搭载预训练的专用场景模型。由于边缘设备的计算资源有限,可在训练阶段根据特征选择和转换对模型进行训练,以提升其性能表现。

应用软件:边缘设备上的软件通过微服务触发 AI 处理,微服务通常基于用户请求来调用;此类软件可运行训练阶段就已具备定制化功能和聚合特性的 AI 模型。

图 1:边缘 AI 工作流程

边缘 AI 的优势

与传统云端模型相比,边缘 AI 具有许多显著优势:

安全性提升:本地数据处理降低了敏感信息在云端传输过程中的泄露风险。

运行可靠性增强:边缘 AI 系统减少了对网络连接的依赖,在间歇性或低带宽的网络环境下仍能保持稳定运行。

灵活性:边缘 AI 支持根据具体应用需求定制模型与功能,这对需求各异的多样化物联网环境至关重要。

低延迟:该模式将数据处理与决策时间降至最低限度,是契合自动驾驶和医疗诊断等实时应用的关键特性。

图2

实施边缘 AI 所面临的挑战

尽管边缘 AI 具备诸多显著优势,其实施仍面临多重挑战。为边缘设备开发机器学习模型,意味着需要处理海量数据、选择合适的算法,并优化模型以适应受限的硬件环境。对于许多制造商,尤其是专注于大规模生产低成本设备的制造商而言,从头开发这些功能所需的投入可能令人望而却步。

这种困境催生了对可编程平台的需求。当前,业界正加速向专用 AI 架构转型,支持在广泛的功耗性能区间实现弹性扩展。这些架构在保持通用设计灵活性的同时,又能满足特殊的处理需求。

专用硬件在边缘 AI 中的作用

随着 AI 和机器学习应用场景的不断拓展,市场对定制化硬件的需求与日俱增,这类专用硬件能够有效应对 AI 技术领域的独特需求。然而,传统的通用处理器在满足 AI 特殊需求,特别是神经网络处理方面表现乏力,尽管其在制造工业和通用工具链方面仍具重要价值。

为填补这一空白,半导体制造商纷纷推出新型 AI 加速器,既能提升通用处理器的性能,又可保留其优势。此类加速器专为神经网络所需的并行处理而设计,为 AI 运算提供更高效的执行路径。

并行架构和矩阵处理器:这些并行架构(比如图形处理器中的架构)对神经网络训练非常奏效。矩阵处理器正是基于此原理设计而成,比如谷歌的张量处理单元专为加快神经网络处理的核心环节——矩阵运算而开发。

存内计算:这项创新技术通过可变电阻器与存储单元的互联,将内存阵列直接转化为神经网络结构,这样有效规避了传统内存访问的瓶颈问题,从而在运算速度和能效方面实现重大突破。

边缘 AI 的未来:创新与机遇

随着边缘 AI 领域的持续进化,为应对日益增长的 AI 处理需求,新技术与新架构不断涌现。其中,微型机器学习 (TinyML) 的进展尤为瞩目,它将 AI 能力延伸至超低功耗设备。虽然 TinyML 并非适用于所有应用场合,但它无疑推动了 AI 在更广泛设备中的普及。

现场可编程门阵列 (FPGA): FPGA 具备动态可重构架构,完美契合 AI 技术的快速发展。相较于 GPU 和 CPU,FPGA 赋予设计者快速构建和测试神经网络的能力,并能针对特定应用需求定制硬件。这种灵活性在航空航天、国防装备、医疗设备等高风险领域至关重要,这些领域的产品生命周期通常较长,且需要支持现场部署新算法。

图形处理器 (GPU):尽管 GPU 拥有强大的并行计算能力,但其能效与散热管理代价不菲。即便如此,在虚拟现实、机器视觉等需要强劲算力的应用中,GPU 仍是首选方案。

中央处理器 (CPU):尽管 CPU 在并行处理方面存在固有缺陷,但仍被广泛集成于各类设备中。Arm 推出的单指令多数据 (SIMD) 架构等创新技术,虽提升了 CPU 运行 AI 算法的性能,但与 GPU、FPGA 等其他计算设备相比,通常存在速度较慢、功耗较高的局限性。

结语

从云端 AI 到边缘 AI 的转型,正在深刻改变物联网系统处理与运用数据的方式。边缘 AI 通过将 AI 处理能力部署至数据源头,显著提升了安全性、可靠性和灵活性,因而得到广泛的应用。然而,边缘 AI 的实施需要全面考量硬件与软件组件的协同,并妥善解决在资源受限环境中部署 AI 的特殊挑战。

随着 AI 普及程度的提高,市场愈发需要擅长解决边缘计算特殊问题的专用硬件。从矩阵处理器、存内计算到 FPGA 和 TinyML,这些新兴技术将重塑新一代边缘 AI 解决方案。如此一来,应用工程师得以紧跟技术发展浪潮,从而充分释放边缘 AI 的潜力,打造更具创新性和竞争力的解决方案。

在 AI 技术日新月异的发展环境中,工程师与开发者必须持续跟进最新技术趋势。如需深入探索 AI、掌握核心要素,并学习如何在实际项目中应用 AI 技术,欢迎访问我们的 AI 中心(AI Hub)。无论是图像分类、语音与手势识别,还是状态监测与预测性维护,AI 中心都能提供全方位支持,为您提供全面的产品解决方案、技术资源和专业知识,助您充分解锁 AI 技术的最大潜能。

关于e络盟

e络盟隶属于Farnell集团。Farnell是全球电子元器件以及工业系统设计、维护和维修产品与技术的分销商,专注快速与可靠交付。从原型研究与设计到生产,Farnell全天候为客户提供可靠的产品与专业服务。凭借逾80年行业经验、48个本地化网站以及3300多名员工的专业团队,Farnell致力于为客户提供构建未来技术所需的各类组件。

Farnell在欧洲经营Farnell品牌,北美经营Newark品牌,亚太地区经营e络盟品牌。同时,Farnell还通过CPC公司直接向英国地区供货。

自2016年起,Farnell加入了全球技术分销商安富利公司(纳斯达克代码:AVT)。如今,双方的合作赋能Farnell支持客户整个产品生命周期,提供独特的分销服务、端到端交付和产品设计专业知识。

欲了解更多信息,敬请访问:http://cn.element14.com。