作者:电子创新网张国斌

据中国科学院官网信息,近日,中国科学院自动化研究所李国齐和徐波团队与相关单位合作,推出类脑脉冲大模型“瞬悉1.0”(SpikingBrain-1.0)。该模型基于团队原创“内生复杂性”理论,在国产千卡GPU算力平台上完成全流程训练和推理,实现大模型在超长序列推理上数量级的效率和速度大幅度提升,展现出构建国产自主可控的新型(非Transformer)大模型架构生态的可行性。研究团队开源了SpikingBrain-1.0-7B模型,开放SpikingBrain-1.0-76B测试网址,同步公开经工业界大规模验证的类脑脉冲大模型SpikingBrain-1.0中英文技术报告(点击原文链接可以下载英文链接)。

这是中国首次提出大规模类脑线性基础模型架构、并首次在国产图形处理器(GPU)算力集群上构建类脑脉冲大模型的训练和推理框架。

据发布论文介绍,当前主流的Transformer模型存在固有缺点,即训练时开销随序列长度呈平方级增长,推理时显存占用随序列长度线性增加,造成资源消耗,导致其处理超长序列能力受限。

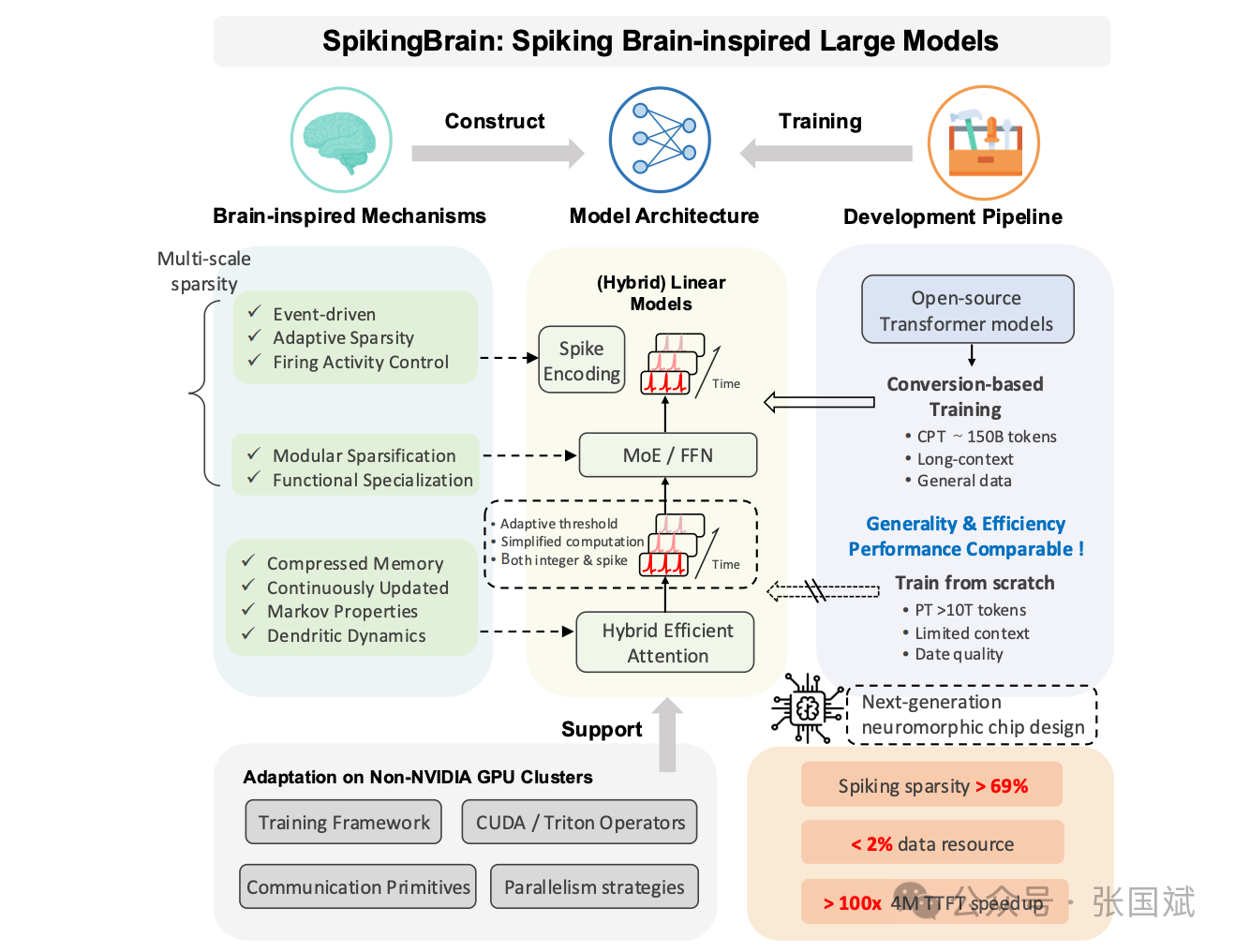

研发团队借鉴大脑神经元内部复杂工作机制,提出“基于内生复杂性”大模型构架方式,打造类脑脉冲大模型“瞬悉1.0”,在理论上建立脉冲神经元内生动力学与线性注意力模型之间的联系,揭示现有线性注意力机制是树突计算的特殊简化形式,展示出一条不断提升模型复杂度和性能的新型可行路径。进一步,研发团队构建并开源了基于脉冲神经元、具有线性及混合线性复杂度的新型类脑基础模型,开发出面向国产GPU集群高效训练和推理框架、Triton算子库、模型并行策略、集群通信原语。

据论坛介绍,SpikingBrain是一个全新的受大脑启发的模型系列,旨在实现高效的长上下文训练和推理。SpikingBrain 利用 (沐曦)MetaX1 GPU 集群,并专注于三个核心方面:i) 模型架构:具有自适应脉冲神经元的线性和混合线性注意架构;ii) 算法优化:一种高效的、基于转换的训练流程,与现有的 LLM 兼容,并配备专用的脉冲编码框架;iii) 系统工程:针对 MetaX 硬件量身定制的训练框架、算子库和并行策略。

利用这些技术,开发团队开发了两个模型:SpikingBrain-7B(线性法学硕士)和 SpikingBrain-76B(混合线性多因素方差法学硕士)。这些模型证明了在非 NVIDIA 平台上进行大规模法学硕士 (LLM) 开发的可行性。SpikingBrain 实现了与开源 Transformer 基线相当的性能,同时使用了极低的数据资源(持续预训练约 1500 亿个 token)。该模型还显著提高了长序列的训练效率,并实现了基于(部分)恒定内存和事件驱动脉冲行为的推理。例如,SpikingBrain-7B 在 4M 令牌序列的首个令牌时间 (TTFT) 上实现了超过 100 倍的加速。我们的训练框架支持在数百块 沐曦MetaX C550 GPU 上进行数周的稳定大规模训练,其中 7B 模型的模型浮点运算利用率 (MFU) 达到 23.4%。此外,提出的脉冲方案实现了 69.15% 的稀疏度,从而实现了低功耗运行。

该大模型摒弃了二次自注意力机制,设计了结合线性、局部和标准注意力模块的混合模型。探索了两种混合策略:层间顺序 (SpikingBrain-7B) 和层内并行 (SpikingBrain76B-A12B)。前者实现了线性复杂度,并在长上下文效率方面表现出色;后者通过更复杂的架构设计提供了更强大的语言建模能力。值得注意的是,线性注意力模型 也与生物系统中的神经元动力学 产生了共鸣。

通过使用统一的注意力图分析,通过重新映射现有 Transformer 模型的权重,将二次注意力模块转换为稀疏滑动窗口和低秩线性注意力。这降低了训练和推理成本,实现了高效的长上下文处理,所需计算量不到从头开始训练的 2%。

受事件驱动的生物神经元启发,研究团队提出了一种脉冲方案,将激活转换为整数脉冲计数,并将其扩展为稀疏脉冲序列。这实现了基于加法的事件驱动计算。该方案支持多种编码格式,包括二进制 {0,1}、三进制 {-1,0,1} 和按位脉冲编码。这些稀疏的事件驱动表示为低功耗推理设计奠定了基础,并可能启发下一代神经形态硬件的开发。

目前该大模型在 沐曦GPU上进行大规模训练和推理:两种模型均在数百块 MetaX C550 GPU 上进行训练,涵盖了从数据预处理到分布式训练和推理的整个流程,这项工作代表了在非NVIDIA平台上首次大规模训练受脑启发的LLM,并在760亿个参数下实现了稳定的训练。

最近中国半导体行业协会副会长、IEEE Fellow、清华大学教授魏少军在新加坡召开的一个行业论坛上警告称,依赖美国硬件将对中国及其亚洲伙伴构成长期风险,呼吁中国与其他亚洲国家摒弃使用英伟达 GPU 进行 AI 训练与推理。中科院的这个大模型为非英伟达GPU高效训练奠定了基础。(详见《魏少军呼吁中国和亚洲国家放弃英伟达GPU,美国网友表示:“早就应该这么做了!”》)

类脑计算背景知识

类脑计算是一种模仿生物大脑信息处理机制的计算模式。它试图从大脑的结构和功能中汲取灵感,构建出更加高效、灵活和智能的计算系统。大脑由大量的神经元通过突触连接而成,神经元通过发放脉冲(动作电位)来进行信息传递和处理。类脑计算模型试图模拟这种神经元和突触的结构以及脉冲的传递过程,以实现类似大脑的计算功能。

类脑脉冲大模型通常具有较高的能效比。由于其模拟了大脑的神经元和突触的工作方式,能够在处理复杂任务时消耗较少的能量。与传统的深度学习模型相比,SNN在处理某些任务时可能只需要消耗极低的功耗,这对于移动设备、物联网设备等对能耗有严格要求的应用场景具有重要意义。

这种模型能够更好地适应动态变化的环境。大脑在处理信息时能够根据环境的变化灵活调整其神经元的活动和连接强度,类脑脉冲大模型也具有类似的特性。它可以通过学习和适应新的输入模式,快速调整自身的参数和结构,从而更好地应对环境的变化和不确定性。

此外,大脑能够同时处理多种模态的信息,如视觉、听觉、触觉等。类脑脉冲大模型也具有这种多模态融合的能力,可以将来自不同传感器或数据源的信息进行整合和处理,从而获得更加全面和准确的感知和理解。例如,在自动驾驶场景中,它可以同时处理摄像头的视觉信息、雷达的测距信息以及车辆的传感器数据,以实现更加安全和可靠的驾驶决策。

与传统的深度学习模型相比,类脑脉冲大模型的可解释性可能更强。由于其结构和工作原理更加接近生物大脑,人们可以通过研究其神经元的活动模式和突触连接的变化来更好地理解模型的决策过程。这有助于提高人们对人工智能系统的信任度,尤其是在一些对安全性要求较高的领域,如医疗、金融等。类脑脉冲大模型可以用于各种智能感知和认知任务,如图像识别、语音识别、自然语言处理等。它能够更好地理解和处理复杂的感知数据,提供更加准确和自然的交互体验。例如,在智能语音助手领域,类脑脉冲大模型可以更好地理解用户的语音指令,并以更加自然和流畅的方式进行回答。

在机器人领域,类脑脉冲大模型可以作为机器人的大脑,控制机器人的运动和行为。它能够实时感知环境的变化,并根据这些变化做出快速的决策和反应,使机器人在复杂环境中具有更好的适应性和灵活性。例如,在工业机器人中,类脑脉冲大模型可以用于控制机器人的手臂运动,实现更加精确和高效的生产操作。

类脑脉冲大模型可以应用于智能决策和规划领域,如自动驾驶、智能交通、金融投资等。它能够根据实时的数据和环境信息,快速生成最优的决策方案,并进行动态调整。例如,在自动驾驶系统中,类脑脉冲大模型可以根据车辆的传感器数据和交通环境信息,实时做出驾驶决策,如加速、减速、变道等,以确保车辆的安全行驶。

类脑脉冲大模型还可以与脑机接口技术相结合,用于研究和开发新型的脑机接口系统。它能够更好地模拟大脑的神经活动,从而实现更加高效和自然的脑机交互。例如,在医疗康复领域,类脑脉冲大模型可以用于控制假肢或外骨骼设备,帮助残疾人恢复运动功能。

注:本文为原创文章,未经作者授权严禁转载或部分摘录切割使用,否则我们将保留侵权追诉的权利