随着高效能运算(HPC)工作负载日益复杂,生成式 AI 正加速整合进现代系统,推动先进内存解决方案的需求因此日益增加。为了应对这些快速演进的需求,业界正积极发展新一代内存架构,致力于提升带宽、降低延迟,同时增加电源效能。DRAM、LPDDR 以及利基型内存技术的突破正重新定义运算效能,而专为 AI 优化的内存方案,则扮演了驱动效率与扩展性的关键角色。华邦的半定制化超高带宽元件 (CUBE) 内存即是此进展的代表,提供高带宽、低功耗的解决方案,支持 AI 驱动的工作负载。本文将探讨内存技术的最新突破、AI 应用日益增长的影响力,以及华邦如何透过策略性布局响应市场不断变化的需求。

先进内存架构与效能扩展

内存技术正迅速演进,以满足 AI、AIoT 与 5G 系统对效能的严苛要求。产业正迎来前所未有的架构革新,DDR5 与 HBM3E 的广泛应用将成为新趋势,这些技术可同时提供更高带宽与更佳的能源效率。DDR5 的单脚位数据速率最高可达 6.4 Gbps,每模块可达 51.2 GB/s,效能几乎为 DDR4 的两倍,且工作电压由 1.2V 降至 1.1V,进一步提升功耗效率。HBM3E 则将带宽推升至每堆栈逾 1.2 TB/s,为 AI 大型训练模型提供理想的效能。然而,其高功耗特性使其不适合用于移动设备与边缘端部署。

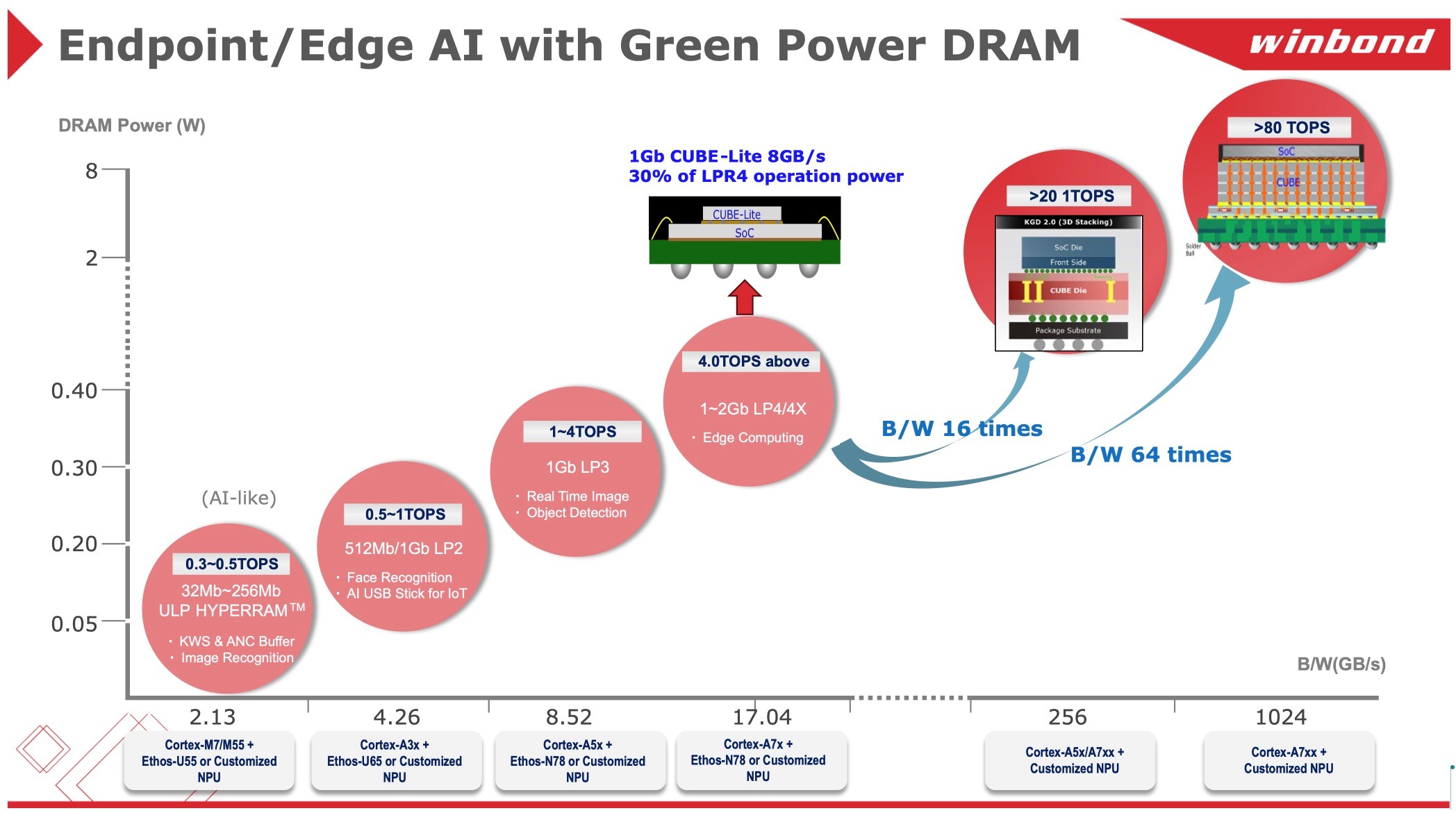

随着 LPDDR6 预计在 2026 年突破 150 GB/s 的带宽,低功耗内存正朝向更高的传输效率与能源效益迈进,以应对 AI 智能型手机与嵌入式 AI 加速器所面临的挑战。华邦正在研发小容量的 DDR5 和 LPDDR4 解决方案,以便对功耗要求应用进行优化。同时,华邦推出了 CUBE 内存,旨在实现超过 1 TB/s 的带宽并降低热耗散。

CUBE 的未来容量预期可扩展至每组 8GB,甚至更高。例如,采用单一光罩区(reticle size)制程的 4Hi WoW 堆栈架构,可实现逾 70GB 的容量与 40TB/s 的带宽,使 CUBE 成为 AI 边缘运算领域中,相较传统内存架构更具优势的替代方案。

此外,CUBE 的子系列 CUBE-Lite 提供 8-16GB/s 的带宽(相当于 LPDDR4x x16/x32),其运作功耗仅为 LPDDR4x 的 30%。在不搭载 LPDDR4 PHY 的情况下,SoC 仅需整合 CUBE-Lite 控制器,即可达成相当于 LPDDR4x 满速的带宽表现,不仅可节省高额的 PHY 授权费用,更能采用 28nm 甚至 40nm 的成熟制程节点,达成原先仅能在 12nm 工艺下实现的效能水平。

此架构特别适用于整合NPU 的 AI-SoC、AI-MCU,可驱动具备电池供电需求的 TinyML 终端装置。搭配 Micro Linux 操作系统 与 AI 模型执行,可应用于 IP 摄影机、AI 眼镜、穿戴式设备等低功耗 AI-ISP 终端场景,有效达成系统功耗优化与芯片面积缩减的双重效益。

生成式 AI 部署下的内存瓶颈

生成式 AI 模型的指数级增长将带来前所未有的内存带宽与延迟挑战。特别是基于 Transformer 架构的 AI 工作负载,对运算吞吐量与高速数据存取能力有极高需求。

以 LLamA2 7B 为例,在 INT8 模式下部署至少需要 7GB 的内存,即便转为 INT4 模式仍需 3.5GB,凸显目前移动设备内存容量的限制。现阶段使用 LPDDR5(带宽 68 GB/s)的 AI 智能型手机,已面临明显瓶颈,市场急需 LPDDR6 的进一步发展。然而,在 LPDDR6 商用化之前,仍需有过渡性解决方案来填补带宽缺口。

从系统层面来看,机器人、自动驾驶汽车与智能传感器等 AI 边缘应用也对功耗与散热提出更严苛的挑战。尽管 JEDEC 标准正朝 DDR6 与 HBM4 演进,以提升带宽利用率,华邦的 CUBE 内存作为一种半定制化架构,则提供符合 AI SoC 要求的高扩展性与高效能替代方案。CUBE 结合了 HBM 级别带宽与低于 10W 的功耗,是边缘 AI 推理任务的理想选择。

散热与能源效率的双重挑战

将大型 AI 模型部署至终端设备,将面临显著的散热与能源效率挑战。AI 工作负载本身即需大量能耗,所产生的高热容易影响系统稳定性与效能表现。

• 装置端内存扩充:

为减少对云端 AI 处理的依赖并降低延迟,行动装置需整合更高容量的内存。然而,传统 DRAM 的扩展已接近物理极限,未来须透过混合式架构,整合高带宽与低功耗内存以突破瓶颈。

• HBM3E 与 CUBE 的比较:

尽管 HBM3E 可实现极高的数据传输速率,但其单堆栈功耗超过 30W,并不适用于移动边缘应用。华邦的 CUBE 则可作为替代型最后层快取 (Last Level Cache, LLC),有效降低对芯片内 SRAM 的依赖,同时维持高速数据存取能力。随着逻辑制程迈入次 7nm 时代,SRAM 面临更严重的缩放瓶颈,凸显新一代快取解决方案的迫切需求。

• 散热优化策略:

AI 处理可能导致单一芯片产生超过 15W 的热负载,因此,如何有效分配功耗与进行热管理成为关键。华邦透过 CUBE 采用的 TSV(Through Silicon Via, 硅穿孔)封装技术,并优化内存的刷新周期,协助在小型化装置中实现 AI 执行的最佳能效。

DDR5 与 DDR6:推升 AI 运算效能的催化剂

DDR5 与 DDR6 的演进标志着 AI 系统架构的重大转折点,带来更高的内存带宽、更低延迟以及更佳的扩展性。

DDR5 采用 8 组 Bank Group 架构与芯片内建的 ECC(Error-Correcting Code , 错误修正码),提供优异的数据完整性与效能,非常适合用于 AI 强化的笔记本电脑与高效能 PC。其单模块的最大传输率达 51.2 GB/s,能支持实时推理、多任务处理与高速数据运算需求。

DDR6 目前仍在研发阶段,预期将实现超过 200 GB/s 的模块带宽,功耗降低约 20%,并针对 AI 加速器进行优化设计,进一步拓展 AI 运算的极限。

华邦在 AI 内存领域的策略领导力

华邦积极推动专为 AI 工作负载与嵌入式处理应用所设计的内存架构创新,其市场策略重点包括:

CUBE 作为 AI 优化内存:透过 TSV(穿硅互连)技术,整合高带宽与低功耗特性,CUBE 是行动与边缘 AI SoC 的理想内存解决方案。

与 OSAT 合作伙伴协同创新:华邦与外包半导体封装与测试(OSAT)伙伴密切合作,推动与下一代 AI 硬件的深度整合,优化内存封装效率并降低系统延迟。

面向未来的内存创新蓝图:华邦专注于 AI 专用内存解决方案、专属高速缓存设计,以及优化 LPDDR 架构,致力于支持高效能运算、机器人与实时 AI 处理等未来应用。

结语

AI 驱动的工作负载、效能扩展的挑战,以及对低功耗内存解决方案的迫切需求,正共同推动内存市场的深度转型。生成式 AI 的迅猛发展,加速了对低延迟、高带宽内存架构的渴求,进一步促使内存与半定制化内存技术持续创新。

华邦凭借其在 CUBE 内存及 DDR5/LPDDR 系列技术上的领先优势,已成为新一代 AI 运算的重要推手。随着 AI 模型日益复杂,市场对兼具高效能与能源效率的内存架构需求将更加迫切。华邦对技术创新的长期承诺,让其持续站稳 AI 内存进化的前沿,实现高效能运算与可持续扩展性之间的最佳平衡。