作者:电子创新网张国斌

在AR/AI眼镜逐步走向消费级、全天候佩戴的新阶段,如何在有限空间与功耗预算下实现强大的感知、计算与显示能力,成为业界共同面对的核心挑战。在4月16日芯原可穿戴专题技术研讨会上,芯原股份解决方案架构工程师刘律宏从应用场景出发,系统阐述了芯原在AR/AI眼镜子系统设计上的思考路径、架构选择以及落地成效,并描绘了可穿戴未来的系统演进方向。

一、AR/AI眼镜:人类感官的智能延伸

他开篇指出AR/AI眼镜正从“显示工具”走向“感知-理解-反馈”的智能终端,广泛应用于以下8类核心场景:

实时导航与信息增强、工业维修指导与远程协作、医疗手术辅助与教学、仓储物流场景识别、实景翻译与名片识别、视觉问答与个人助理、虚拟内容沉浸体验和环境建模与SLAM定位

这些应用的共性需求是:高计算、高实时性、高能效,这使得系统架构不仅需要高性能IP支持,更需要具备灵活可配置、低功耗、紧耦合的系统设计能力。

二、从性能堆叠到能效平衡:AR/AI眼镜设计的现实瓶颈

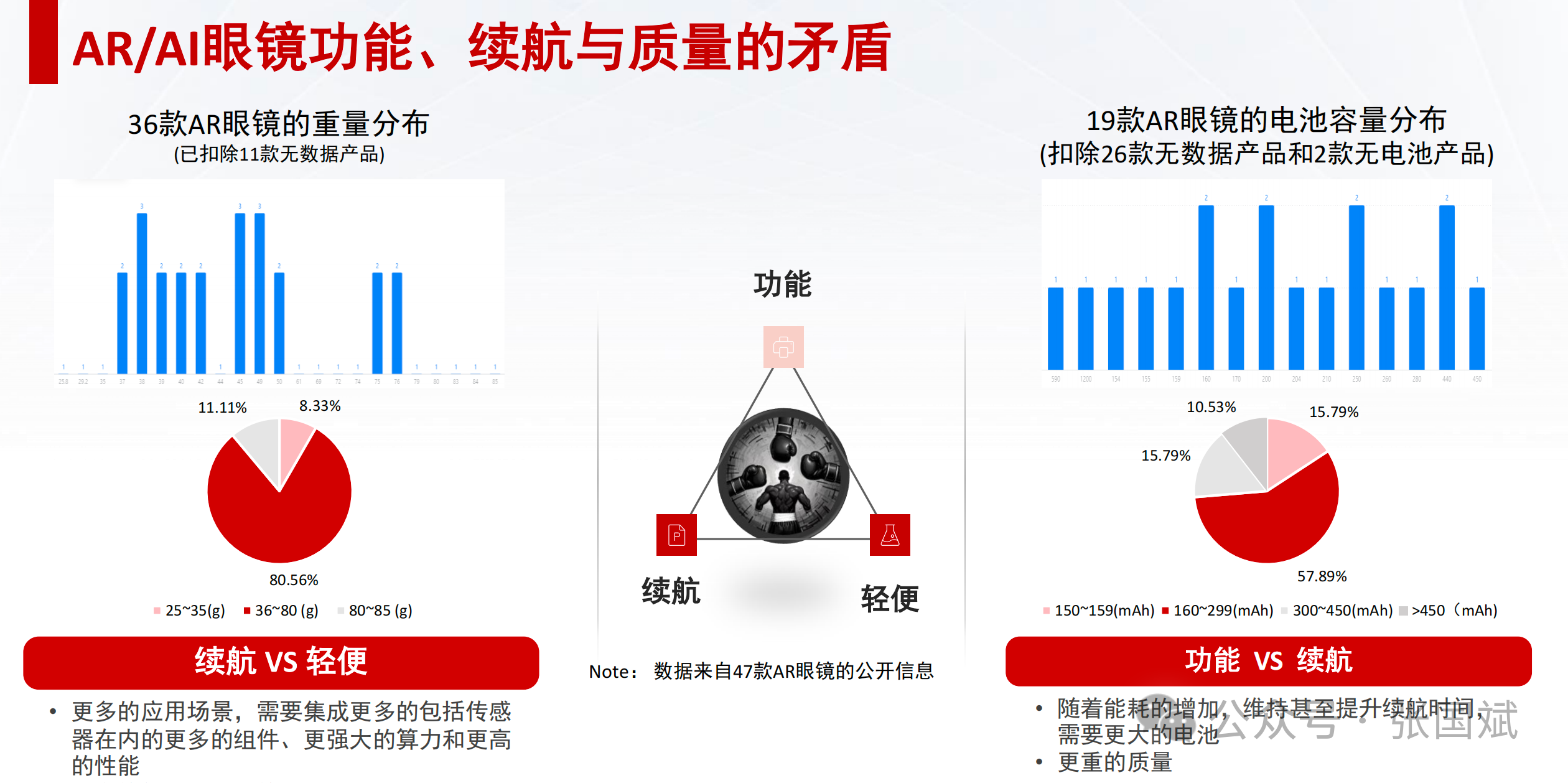

他指出随着功能增强,AR/AI眼镜面临“性能—重量—续航”三角难题。数据显示:主流AR眼镜重量集中在30g-80g之间;电池容量普遍在450mAh以内;场景越复杂,续航下降越明显,3D解剖类产品即便配1200mAh电池,续航仍不到5小时。这意味着:系统级优化,尤其是子系统间的数据路径压缩与功耗管理,是突破瓶颈的关键手段。

三、芯原可穿戴子系统解决方案:三层支撑,五类产品,全向定制

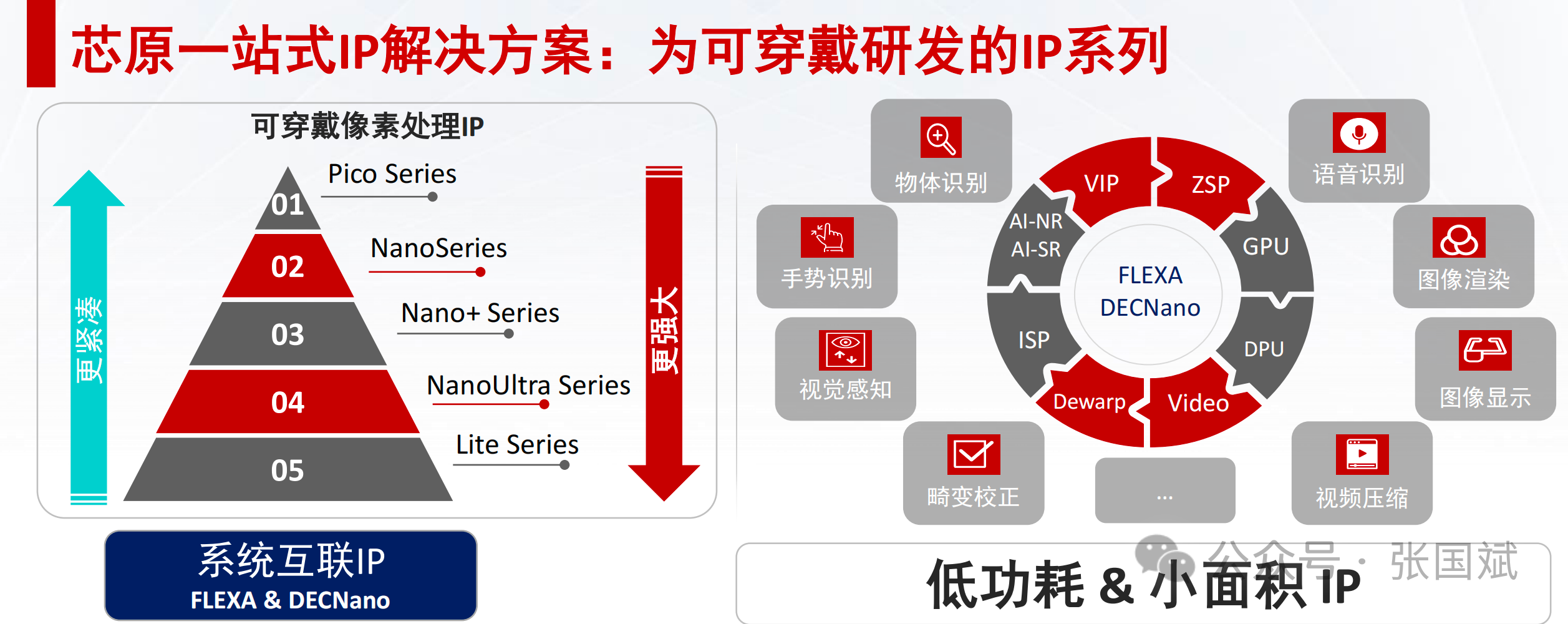

据他介绍,芯原可穿戴子系统解决方案实现三层支撑,五类产品,全向定制:

1. 轻量级、可配置的IP系列

芯原根据可穿戴设备对面积和能耗的极致需求,打造了五大系列IP组合,包括:

GPU/NPU/ISP/Video Codec/Dewarp,可实现图像识别、手势识别、视觉感知、图像渲染、图像显示、音视频处理等。此外,面向不同产品落地,提供Pico、Nano、Nano+ 等子系列,支持灵活组合、按需定制。

2. 系统级互联与压缩技术

为了最大化数据效率并降低系统功耗,芯原自研了FLEXA互联技术与DECNano有损压缩技术:

FLEXA互联:采用点对点数据互联,避免冗余DDR访问,提升互联效率,降低带宽需求;

DECNano压缩:压缩率可达2-4倍,同时保障图像质量,减轻PSRAM压力,减少系统外存访问;

3. Lite版软件生态支持

在软件方面,芯原提供适配RTOS、Linux、Android等操作系统的精简版IP软件库,具有极小代码体积、极低外存占用和极小CPU负载的特点。可以形成IP + 架构 + 软件的一体化可穿戴解决方案。

四、真实项目落地:子系统设计带来的性能跃升

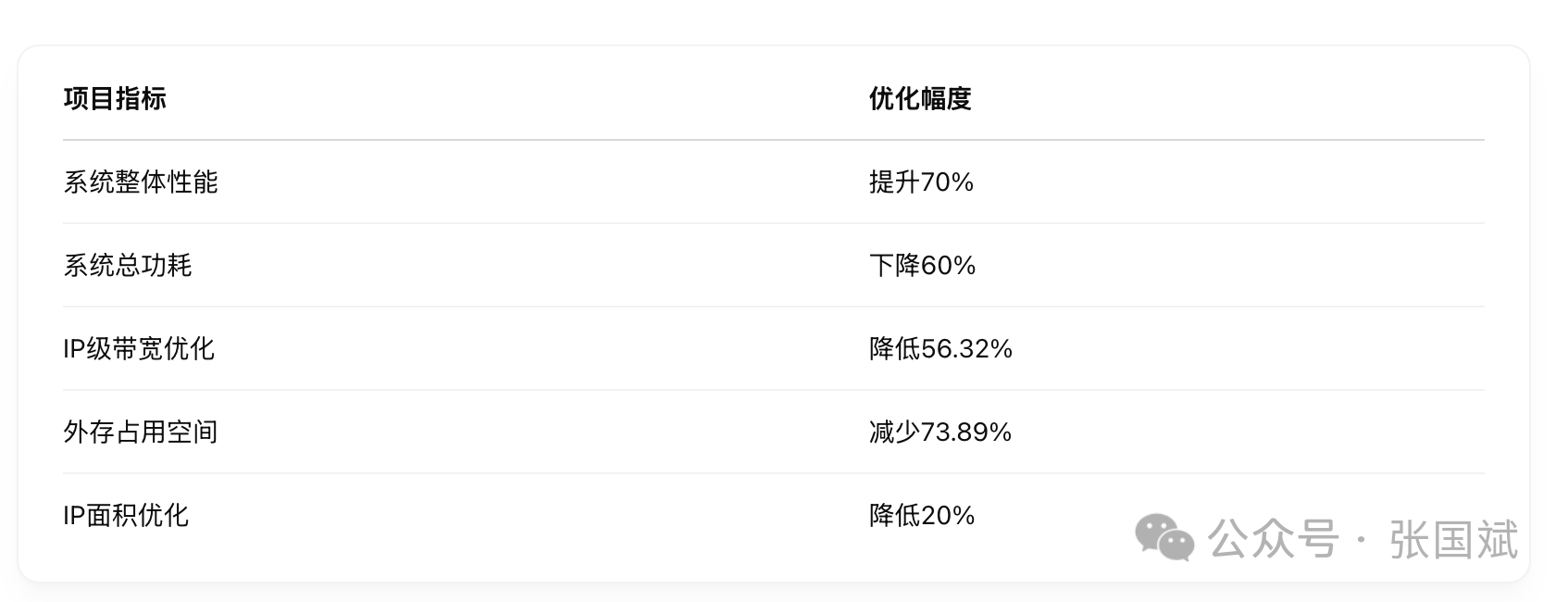

据他介绍,芯原在客户实际项目中,帮助其解决了因系统设计粗放带来的带宽超标、性能不足问题。通过芯原可穿戴子系统的引入与以下优化措施:

IP替换:选用低功耗、高集成的芯原可穿戴IP

数据通路重构:优化Data Path,FLEXA取代部分DDR访问

压缩机制应用:全链路应用DECNano压缩技术

取得如下成果:

该方案还已落地于AR/VR设备的视频采集与显示子系统,展现出极低延迟的视频编解码性能。

五、未来发展策略:四大方向持续迭代

他表示芯原明确可穿戴系统技术的未来演进,将从以下四个方向持续投入:

1. IP持续进化

基于客户反馈,持续扩展更高PPA效率、更小Area的新一代轻量IP组合

2. 系统架构提升

强化子系统之间协同,研发更高效互联与“内存最小化”架构,如No-DDR设计路径

3. 核心技术拓展

探索新型算法与感知模块(如EIS防抖、SLAM定位、低功耗AI加速),拓展AR/AI眼镜智能场景落地能力

4. 生态协同共建

与行业客户深度合作,从芯片设计到系统整合构建AI眼镜“生态共筑”机制,实现创新闭环

他指出AI眼镜的发展不仅仅是一次智能硬件的小升级,更是一次人机交互范式的全面转变。芯原用其在IP设计、系统集成与技术创新上的深厚积淀,正为AI眼镜构建从“芯”到“用”的全栈生态底座。未来这场AI智能终端革命,不只是技术的突破,更是生态的共赢。而芯原,将继续“以创新为舟,载客户到成功的彼岸”。

注:本文为原创文章,未经作者授权严禁转载或部分摘录切割使用,否则我们将保留侵权追诉的权利