作者:电子创新网张国斌

近年来,随着端侧AI算力的不断增强和低功耗设计的日益成熟,AI眼镜这一品类逐步从概念走向市场。特别是在DeepSeek等先进模型的引领下,AI眼镜被赋予了更多的想象空间,成为空间计算新时代的重要入口。在芯原可穿戴专题技术研讨会上芯原股份高级设计总监郝鹏鹏围绕AI眼镜芯片的设计思路、技术路径与产品实践,提供了行业发展的一线视角。

一、AI眼镜芯片发展历程:从“探索”走向“落地”

郝鹏鹏认为AI眼镜的发展可以分为三个阶段:

萌芽期:以Google Glass为代表,开启了可穿戴视觉计算的先河,但由于算力、功耗与生态问题未能规模化落地;

低潮期:早期厂商纷纷退场,市场一度沉寂;

爆发期及AI Plus时代:2019年后,AI技术进步与硬件革新推动产品复苏,进入“AI+”的新阶段。

当前,以DeepSeek等轻量级模型为代表的端侧AI能力成为关键突破口,催生出一批新兴AI眼镜方案,加速了产品的商品化进程。

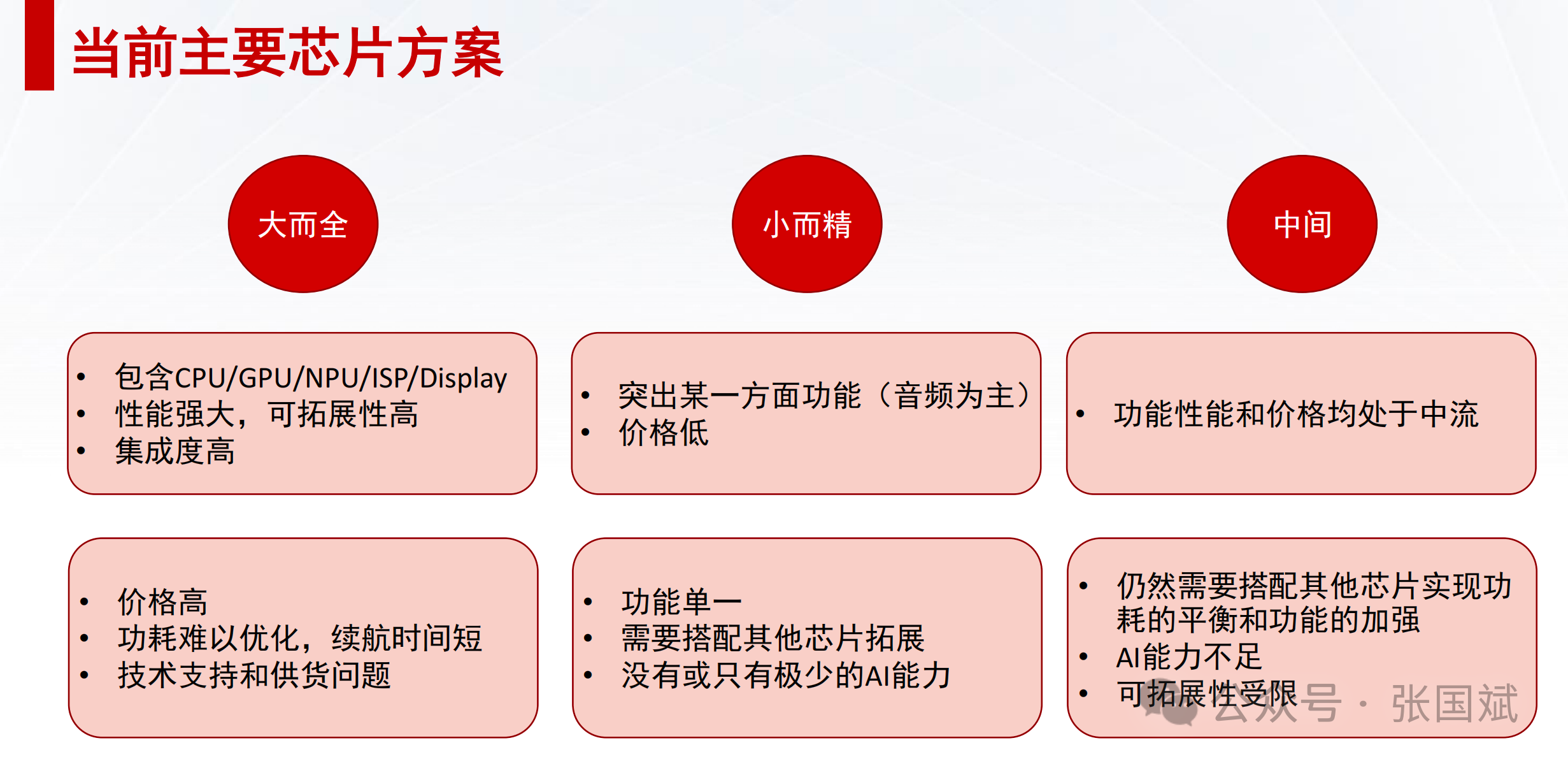

二、当前芯片方案三种主流模式

郝鹏鹏将现有AI眼镜芯片方案分为三类:

大而全型SoC:如某些高集成平台,拥有强大的CPU、GPU、NPU及ISP等功能单元,可覆盖多种计算与显示需求。但成本高、功耗大,不适合轻量、全天候佩戴场景。

小而精型SoC:功能聚焦如音频处理,价格低、成熟度高,适用于单一场景,如语音助手。但扩展能力有限,难以支持复合型AI体验。

平衡型方案:在成本、功能、功耗间取平衡,适合中端AI眼镜,但AI算力仍有限,拓展性受限。

三、芯原AI眼镜芯片技术方案:平衡“性能-功耗-成本”

他表示芯原的AI眼镜芯片方案核心思路是:面向定制化、强调可扩展性、突出低功耗AI能力。其设计哲学聚焦于“性能、续航、成本”的三角权衡,核心包括以下几点:

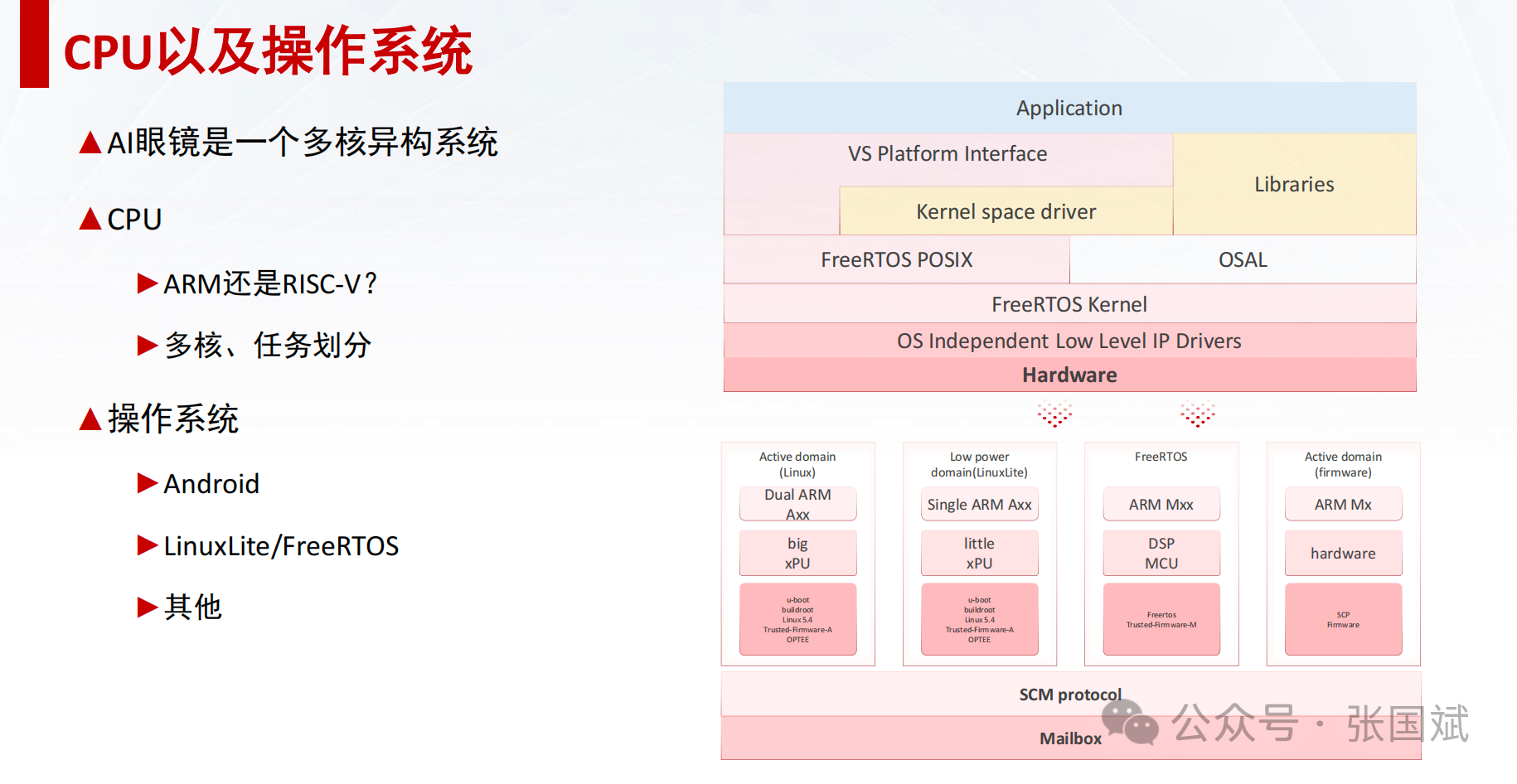

1. 多核异构设计与电源域划分

采用多核架构,根据不同任务分配功耗资源;

超过20个电源域的划分,实现动态功耗控制;

RTS待机模式功耗低至5μW,常规待机功耗仅3.8mW,满足全天候佩戴需求。

2. 轻量显示与AI结合的灵活策略

初期以无显示或轻显示(如1080P)为主,减少功耗压力;

AI超分辨率技术用于低分辨率输入,通过芯原GPU和显示控制器进行图像质量提升;

显示路径整体数据通路保持低带宽,最后阶段动态插值提升显示效果。

3. 端侧AI处理能力强化

支持独立AI处理模块,可实现两核或四核DSP架构;

集成FLEXA技术(无DDR架构)和New Break算法硬化技术,实现专用AI处理通路;

实现Token化输出,提升数据传输效率与隐私保护能力。

4. 通讯模块采用外挂策略

避免SoC内冗余设计,增强通信模块可裁剪性;

外挂蓝牙、Cat-1等低功耗通信芯片,可按需关闭以节省能耗。

5. 操作系统适配轻量化平台

大任务适配Linux Lite;

小型实时任务运行FreeRTOS;

支持RISC-V或ARM Cortex-M内核,灵活选型,提升成本控制能力。

四、AI眼镜芯片演进路线展望

他表示从芯原的实践与观察来看,AI眼镜芯片未来发展将沿着以下路径逐步演进:

演进阶段 核心特征

初级阶段 轻量级AI模型,无显示或轻显示,低功耗单芯片主导

中级阶段 较强AI能力 + 超分显示,支持摄像头/语音识别,轻交互体验

高级阶段 重AI任务(如图像生成、多模态分析)、AR显示与空间感知融合

泛在阶段 与IoT融合、全时联网、高度个性化定制芯片架构

他分享了两个设计实例:

AIoT智能摄像头:依靠2节AA电池可连续使用2年,体现极致低功耗设计能力;

AI眼镜芯片:高度电源域划分、无需DDR、Token生成支持、多核AI处理,完美契合全天候轻量佩戴场景。

AI眼镜芯片的设计正在经历从“通用SoC适配”向“专用定制优化”转变。芯原通过其IP积累、多核异构SoC平台与完整的软硬件协同能力,为AI眼镜的快速商用化探索了一条具备现实可行性和技术前瞻性的路径。

未来,AI眼镜将不再是一个小众实验产品,而可能成为真正的“下一代移动终端”,而芯片作为其“神经中枢”,其架构设计能力将成为决定产品成败的核心。

注:本文为原创文章,未经作者授权严禁转载或部分摘录切割使用,否则我们将保留侵权追诉的权利