Graphcore今日宣布发布最新产品IPU-POD128和IPU-POD256。IPU-POD128和IPU-POD256是Graphcore迄今为止发布的最大型的产品,分别能够提供32 petaFLOPS和64 petaFLOPS的AI计算。IPU-POD128和IPU-POD256的发布意味着Graphcore进一步扩展了其在超级计算机领域的业务范围,将为超级计算机领域提供超强AI算力。

IPU-POD128和IPU-POD256的发布进一步兑现了Graphcore在AI旅程的每个阶段为客户提供服务的承诺。IPU-POD16仍然是理想的探索平台,IPU-POD64适用于想要建立AI计算的客户,而IPU-POD128和IPU-POD256适合需要实现进一步快速增长的客户,可以在整个系统中更快地训练基于Transformer的大型语言模型,在生产中运行大规模商业AI推理应用程序,通过将系统划分为更小、更灵活的vPOD,为更多开发人员提供IPU访问权限,或者通过在整个系统中探索GPT和GNN等新兴模型来实现科学突破,是云超大规模企业(Cloud Hyperscaler)、国家科学计算实验室以及在金融服务或制药等市场拥有大型AI团队的企业的理想之选。

首批部署IPU-POD128的客户包括韩国科技巨头Korea Telecom(KT)。为了不断满足日益增长的超大规模AI HPC环境市场需求,KT正与Graphcore合作,将其所拥有的IPU-POD64升级为IPU-POD128,以增加为客户所提供的“超大规模AI服务”。

KT云/数字体验业务部高级副总裁Mihee Lee表示:“通过此次升级,预计我们的AI计算规模将增加至32 petaFLOPS的AI计算,使更多元的客户能够使用KT的先进AI计算技术进行大规模AI模型训练和推理。”

与其他IPU-POD系统一样,AI计算和服务器的解聚意味着IPU-POD128和IPU-POD256可以在优化后,为不同的AI工作负载提供最大性能,实现最佳总体拥有成本(TCO)。例如一个以自然语言处理(NLP)为主的系统可以只使用2台服务器;而更多的数据密集型任务,例如计算机视觉任务等可以使用8台服务器。此外,系统存储可以使用来自Graphcore最近公布的存储合作伙伴所提供的技术,围绕特定的AI工作负载进行优化。

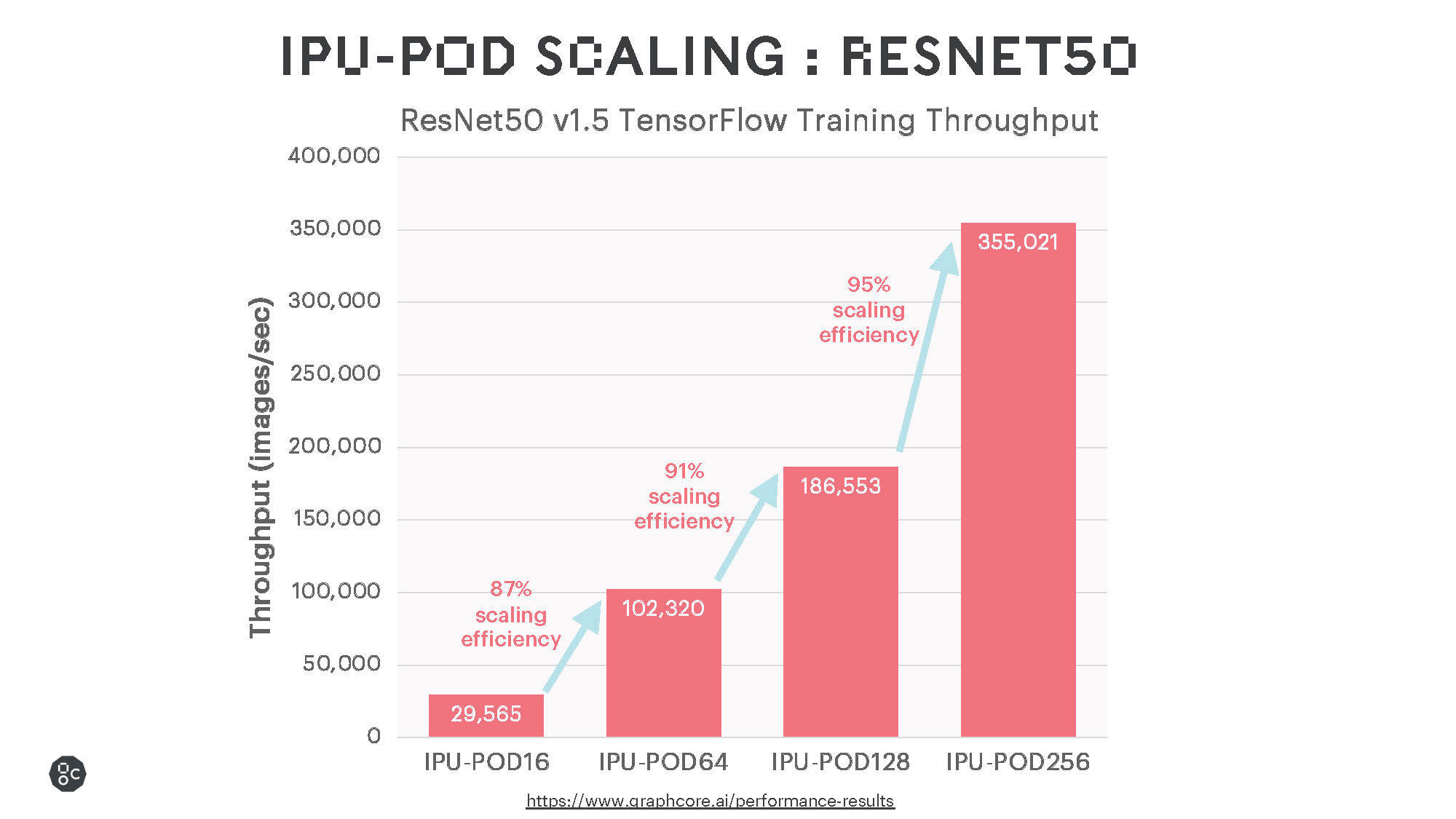

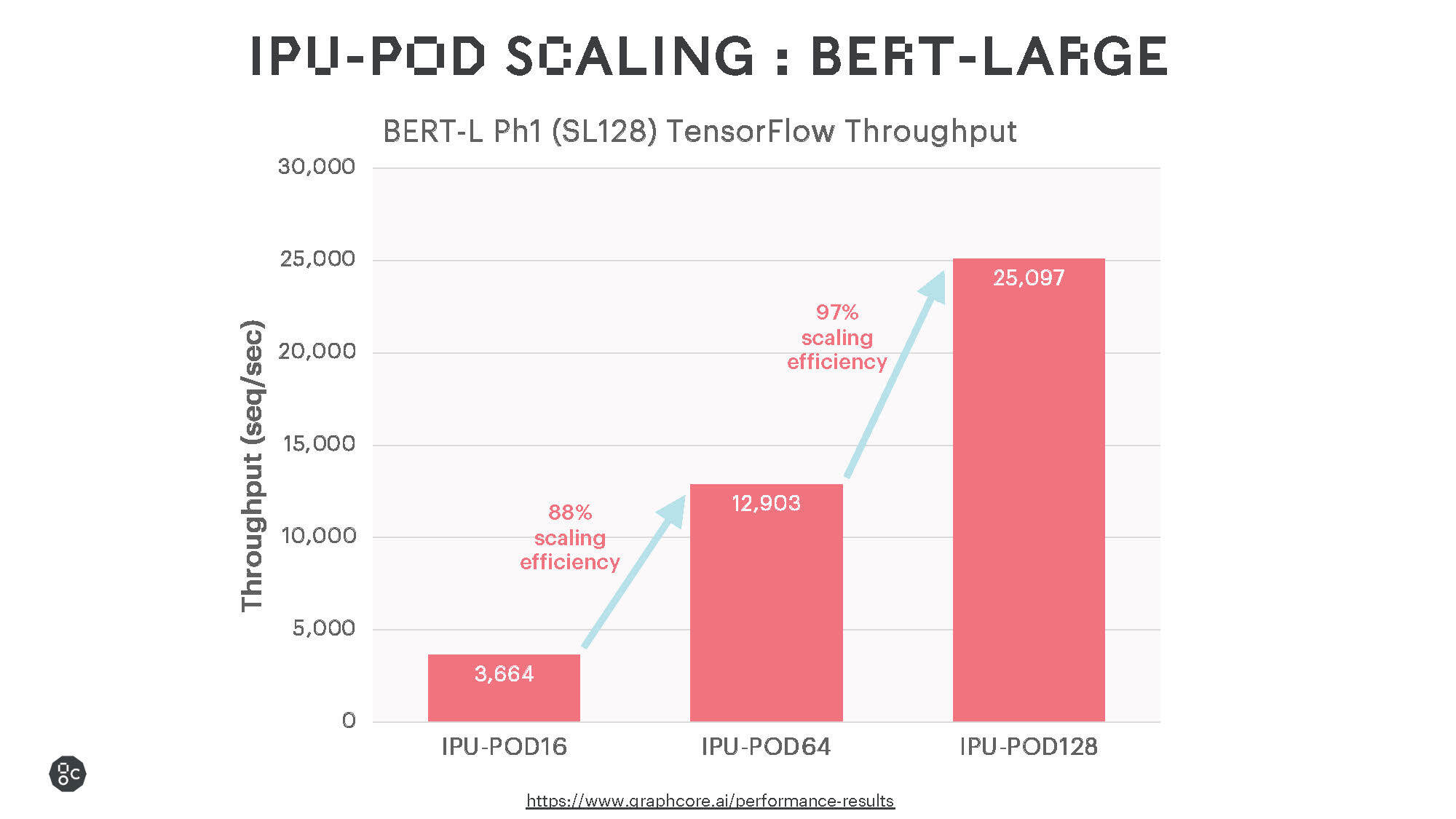

广泛使用的语言和视觉模型的结果显示,IPU-POD128和IPU-POD256具有极为出色的训练性能和高效的扩展能力,随着未来软件的优化,这两大产品有望进一步提高性能。

将Graphcore计算扩展到IPU-POD128和IPU-POD256需要大量使能技术支持,其中既包括硬件技术也包括软件技术。Graphcore将携手合作伙伴为全球客户部署IPU-POD256和IPU-POD128,客户可以从云端或Atos等Graphcore的合作伙伴处获取IPU-POD256和IPU-POD128。

Atos集团高级副总裁兼HPC和Quantum主管Agnès Boudot表示:“我们十分高兴能将IPU-POD128和IPU-POD256加入到我们的Atos ThinkAI产品组合中,使我们的客户能够在众多领域更快探索和部署更大、更具创新性的AI模型。”

如欲了解有关IPU-POD128和IPU-POD256的更多信息,请访问https://www.graphcore.ai/products/mk2/ipu-pod128和https://www.graphcore.ai/products/mk2/ipu-pod256。

关于Graphcore

Graphcore的智能处理器(IPU)硬件和Poplar软件帮助创新者在机器智能方面实现新突破。IPU是第一个专为机器智能设计的处理器,与通常用于人工智能的其他计算硬件相比,具有显著的性能优势。

Graphcore已从领先的金融和战略投资者那里筹集了超过7.1亿美元资金,总部位于英国布里斯托,在英国剑桥和伦敦、中国北京、挪威奥斯陆、美国帕拉奥图、德国慕尼黑、法国巴黎、韩国首尔、日本东京、新加坡设有办公室。

获取更多Graphcore资讯,阅读深度技术文章,并与其他创新者们一起交流,敬请访问https://www.graphcore.cn/或者关注我们的官方微信公众号“Graphcore”。